Générer et rechercher des embeddings multimodaux

Ce tutoriel explique comment générer des embeddings multimodaux pour les images et le texte à l'aide de BigQuery et Vertex AI, puis comment utiliser ces embeddings pour effectuer une recherche sémantique de texte vers image.

Ce tutoriel couvre les tâches suivantes :

- Créer une table d'objets BigQuery sur des données d'image dans un bucket Cloud Storage.

- Explorer les données d'image à l'aide d'un notebook Colab Enterprise dans BigQuery.

- Créer un modèle distant BigQuery ML qui cible le modèle de fondation

multimodalembeddingde Vertex AI. - Utiliser le modèle distant avec la fonction

AI.GENERATE_EMBEDDINGpour générer des embeddings à partir des images de la table d'objets. - Corriger les erreurs de génération d'embeddings.

- (Facultatif) Créer un index vectoriel pour indexer les embeddings d'images.

- Créer un embedding textuel (ou "plongement textuel") pour une chaîne de recherche donnée.

- Utiliser la fonction

VECTOR_SEARCHpour effectuer une recherche sémantique d'embeddings d'images semblables à l'embedding textuel. - Visualiser les résultats à l'aide d'un notebook

Ce tutoriel utilise des images d'art du domaine public provenant du Métrotrometus of Art, disponibles dans le bucket gcs-public-data--met de Cloud Storage.

Rôles requis

Pour exécuter ce tutoriel, vous devez disposer des rôles IAM (Identity and Access Management) suivants :

- Créer et utiliser des ensembles de données, des connexions, des modèles et des notebooks BigQuery : administrateur BigQuery Studio (

roles/bigquery.studioAdmin). - Accordez des autorisations au compte de service de la connexion : Administrateur IAM du projet (

roles/resourcemanager.projectIamAdmin).

Ces rôles prédéfinis contiennent les autorisations requises pour effectuer les tâches décrites dans ce document. Pour afficher les autorisations exactes requises, développez la section Autorisations requises :

Autorisations requises

- Créez un ensemble de données :

bigquery.datasets.create - Créer, déléguer et utiliser une connexion :

bigquery.connections.* - Définissez la connexion par défaut :

bigquery.config.* - Définissez les autorisations du compte de service :

resourcemanager.projects.getIamPolicyetresourcemanager.projects.setIamPolicy - Créez une table d'objets :

bigquery.tables.createetbigquery.tables.update - Créez un modèle et exécutez l'inférence :

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

- Créer et utiliser des notebooks :

resourcemanager.projects.getresourcemanager.projects.listbigquery.config.getbigquery.jobs.createbigquery.readsessions.createbigquery.readsessions.getDatabigquery.readsessions.updatedataform.locations.getdataform.locations.listdataform.repositories.create

.dataform.repositories.listdataform.collections.createdataform.collections.listaiplatform.notebookRuntimeTemplates.applyaiplatform.notebookRuntimeTemplates.getaiplatform.notebookRuntimeTemplates.listaiplatform.notebookRuntimeTemplates.getIamPolicyaiplatform.notebookRuntimes.assignaiplatform.notebookRuntimes.getaiplatform.notebookRuntimes.listaiplatform.operations.listaiplatform.notebookRuntimeTemplates.apply

Vous pouvez également obtenir ces autorisations avec des rôles personnalisés ou d'autres rôles prédéfinis.

Coûts

Dans ce document, vous utilisez les composants facturables de Cloud de Confiance by S3NSsuivants :

- BigQuery ML: You incur costs for the data that you process in BigQuery.

- Vertex AI: You incur costs for calls to the Vertex AI service that's represented by the remote model.

Pour en savoir plus sur les tarifs de BigQuery, consultez la page Tarifs de BigQuery dans la documentation BigQuery.

Pour en savoir plus sur les tarifs de Vertex AI, consultez la page Tarifs de Vertex AI.

Avant de commencer

-

In the Cloud de Confiance console, on the project selector page, select or create a Cloud de Confiance project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator role

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Cloud de Confiance project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.

Créer un ensemble de données

Créez un ensemble de données BigQuery pour stocker votre modèle de ML.

Console

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans le volet Explorateur, cliquez sur le nom de votre projet.

Cliquez sur Afficher les actions > Créer un ensemble de données.

Sur la page Créer un ensemble de données, procédez comme suit :

Dans le champ ID de l'ensemble de données, saisissez

bqml_tutorial.Pour Type d'emplacement, sélectionnez Multirégional, puis sélectionnez US (plusieurs régions aux États-Unis).

Conservez les autres paramètres par défaut, puis cliquez sur Créer un ensemble de données.

bq

Pour créer un ensemble de données, exécutez la commande bq mk en spécifiant l'option --location. Pour obtenir la liste complète des paramètres possibles, consultez la documentation de référence sur la commande bq mk --dataset.

Créez un ensemble de données nommé

bqml_tutorialavec l'emplacement des données défini surUSet la descriptionBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Au lieu d'utiliser l'option

--dataset, la commande utilise le raccourci-d. Si vous omettez-det--dataset, la commande crée un ensemble de données par défaut.Vérifiez que l'ensemble de données a été créé :

bq ls

API

Appelez la méthode datasets.insert avec une ressource d'ensemble de données définie.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Avant d'essayer cet exemple, suivez les instructions de configuration pour BigQuery DataFrames du guide de démarrage rapide de BigQuery DataFrames. Pour en savoir plus, consultez la documentation de référence sur BigQuery DataFrames.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer les ADC pour un environnement de développement local.

Créer la table d'objets

Créez une table d'objets sur les images artistiques dans le bucket gcs-public-data--met public de Cloud Storage.

La table d'objets permet d'analyser les images sans les déplacer depuis Cloud Storage.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez la requête suivante :

CREATE OR REPLACE EXTERNAL TABLE `bqml_tutorial.met_images` WITH CONNECTION DEFAULT OPTIONS ( object_metadata = 'SIMPLE', uris = ['gs://gcs-public-data--met/*'] );

Explorer les données d'image

Créez un notebook Colab Enterprise dans BigQuery pour explorer les données d'image.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Connectez le notebook à l'environnement d'exécution par défaut.

Configurez le notebook :

- Ajoutez une cellule de code au notebook.

Copiez et collez le code suivant dans la cellule de code :

#@title Set up credentials from google.colab import auth auth.authenticate_user() print('Authenticated') PROJECT_ID='PROJECT_ID' from google.cloud import bigquery client = bigquery.Client(PROJECT_ID)Remplacez

PROJECT_IDpar le nom du projet que vous utilisez pour ce tutoriel.Exécutez la cellule de code.

Activez l'affichage des tables :

- Ajoutez une cellule de code au notebook.

Copiez et collez le code suivant dans la cellule de code :

#@title Enable data table display %load_ext google.colab.data_tableExécutez la cellule de code.

Créez une fonction permettant d'afficher les images :

- Ajoutez une cellule de code au notebook.

Copiez et collez le code suivant dans la cellule de code :

#@title Util function to display images import io from PIL import Image import matplotlib.pyplot as plt import tensorflow as tf def printImages(results): image_results_list = list(results) amt_of_images = len(image_results_list) fig, axes = plt.subplots(nrows=amt_of_images, ncols=2, figsize=(20, 20)) fig.tight_layout() fig.subplots_adjust(hspace=0.5) for i in range(amt_of_images): gcs_uri = image_results_list[i][0] text = image_results_list[i][1] f = tf.io.gfile.GFile(gcs_uri, 'rb') stream = io.BytesIO(f.read()) img = Image.open(stream) axes[i, 0].axis('off') axes[i, 0].imshow(img) axes[i, 1].axis('off') axes[i, 1].text(0, 0, text, fontsize=10) plt.show()Exécutez la cellule de code.

Affichez les images :

- Ajoutez une cellule de code au notebook.

Copiez et collez le code suivant dans la cellule de code :

#@title Display Met images inspect_obj_table_query = """ SELECT uri, content_type FROM bqml_tutorial.met_images WHERE content_type = 'image/jpeg' Order by uri LIMIT 10; """ printImages(client.query(inspect_obj_table_query))Exécutez la cellule de code.

Le résultat doit ressembler à ce qui suit :

Enregistrez le notebook sous le nom

met-image-analysis.

Créer le modèle distant

Créez un modèle distant représentant un modèle d'embedding multimodal Vertex AI hébergé :

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez la requête suivante :

CREATE OR REPLACE MODEL `bqml_tutorial.multimodal_embedding_model` REMOTE WITH CONNECTION DEFAULT OPTIONS (ENDPOINT = 'multimodalembedding@001');

L'exécution de la requête prend plusieurs secondes, après quoi vous pouvez accéder au modèle

multimodal_embedding_modelqui apparaît dans l'ensemble de donnéesbqml_tutorial. Étant donné que la requête utilise une instructionCREATE MODELpour créer un modèle, il n'y a aucun résultat de requête.

Générer des embeddings d'images

Générez des embeddings à partir des images de la table d'objets à l'aide de la fonction AI.GENERATE_EMBEDDING, puis écrivez-les dans une table pour les utiliser ultérieurement. La génération d'embeddings est une opération coûteuse. La requête utilise donc une sous-requête incluant LIMIT pour limiter la génération d'embeddings à 10 000 images au lieu d'intégrer l'ensemble de données complet composé de 601 294 images. Cela permet également de maintenir le nombre d'images sous la limite de 25 000 pour la fonction AI.GENERATE_EMBEDDING. L'exécution de cette requête prend environ 40 minutes.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez la requête suivante :

CREATE OR REPLACE TABLE `bqml_tutorial.met_image_embeddings` AS SELECT * FROM AI.GENERATE_EMBEDDING( MODEL `bqml_tutorial.multimodal_embedding_model`, (SELECT * FROM `bqml_tutorial.met_images` WHERE content_type = 'image/jpeg' LIMIT 10000))

Corriger les erreurs de génération d'embeddings

Recherchez et corrigez les erreurs de génération d'embeddings. La génération d'embeddings peut échouer en raison des quotas de l'IA générative sur Vertex AI ou de l'indisponibilité du service.

La fonction AI.GENERATE_EMBEDDING renvoie les détails de l'erreur dans la colonne status. Cette colonne est vide si la génération d'embeddings a réussi, ou contient un message d'erreur en cas d'échec de la génération d'embeddings.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, exécutez la requête suivante pour vérifier la présence d'échecs de génération d'embeddings :

SELECT DISTINCT(status), COUNT(uri) AS num_rows FROM bqml_tutorial.met_image_embeddings GROUP BY 1;

Si des lignes contenant des erreurs sont renvoyées, supprimez celles pour lesquelles la génération d'embeddings a échoué :

DELETE FROM `bqml_tutorial.met_image_embeddings` WHERE status = 'A retryable error occurred: RESOURCE_EXHAUSTED error from remote service/endpoint.';

Créer un index vectoriel

Vous pouvez éventuellement utiliser l'instruction CREATE VECTOR INDEX pour créer l'index vectoriel met_images_index sur la colonne embedding de la table met_images_embeddings.

Un index vectoriel vous permet d'effectuer une recherche vectorielle plus rapidement, avec le compromis de réduire le rappel et donc de renvoyer des résultats plus approximatifs.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez la requête suivante :

CREATE OR REPLACE VECTOR INDEX `met_images_index` ON bqml_tutorial.met_image_embeddings(embedding) OPTIONS ( index_type = 'IVF', distance_type = 'COSINE');

L'index vectoriel est créé de manière asynchrone. Pour vérifier si l'index vectoriel a été créé, interrogez la vue

INFORMATION_SCHEMA.VECTOR_INDEXESet vérifiez que la valeurcoverage_percentageest supérieure à0et que la valeurlast_refresh_timen'est pasNULL:SELECT table_name, index_name, index_status, coverage_percentage, last_refresh_time, disable_reason FROM bqml_tutorial.INFORMATION_SCHEMA.VECTOR_INDEXES WHERE index_name = 'met_images_index';

Générer un embedding pour le texte de recherche

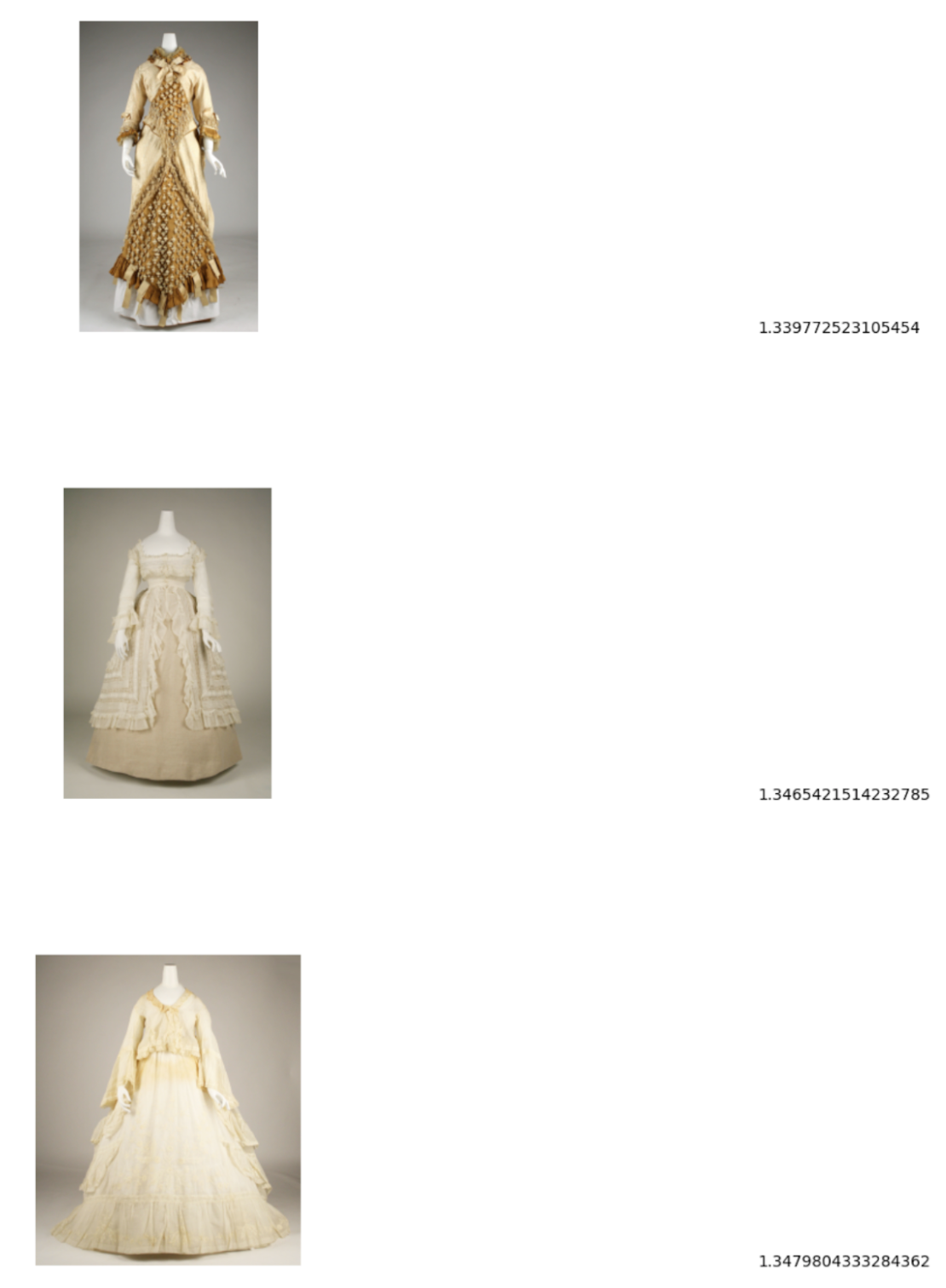

Pour rechercher des images correspondant à une chaîne de recherche de texte spécifiée, vous devez d'abord créer un embedding textuel (ou "plongement textuel") pour cette chaîne. Utilisez le même modèle distant pour créer l'embedding textuel que celui utilisé pour créer les embeddings d'images, puis écrivez l'embedding textuel dans une table pour l'utiliser lors d'une étape suivante. La chaîne de recherche est pictures of white or cream colored dress from victorian era.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, saisissez la requête suivante :

CREATE OR REPLACE TABLE `bqml_tutorial.search_embedding` AS SELECT * FROM AI.GENERATE_EMBEDDING( MODEL `bqml_tutorial.multimodal_embedding_model`, ( SELECT 'pictures of white or cream colored dress from victorian era' AS content ) );

Effectuer une recherche sémantique de texte vers image

Utilisez la fonction VECTOR_SEARCH pour effectuer une recherche sémantique d'images qui correspondent le mieux à la chaîne de recherche représentée par l'embedding textuel.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Dans l'éditeur de requête, exécutez la requête suivante pour effectuer une recherche sémantique et écrire les résultats dans une table :

CREATE OR REPLACE TABLE `bqml_tutorial.vector_search_results` AS SELECT base.uri AS gcs_uri, distance FROM VECTOR_SEARCH( TABLE `bqml_tutorial.met_image_embeddings`, 'embedding', TABLE `bqml_tutorial.search_embedding`, 'embedding', top_k => 3);

Visualiser les résultats de la recherche sémantique

Visualiser les résultats de la recherche sémantique à l'aide d'un notebook.

Dans la console Cloud de Confiance , accédez à la page BigQuery.

Ouvrez le notebook

met-image-analysisque vous avez créé précédemment.Visualisez les résultats de la recherche vectorielle :

- Ajoutez une cellule de code au notebook.

Copiez et collez le code suivant dans la cellule de code :

query = """ SELECT * FROM `bqml_tutorial.vector_search_results` ORDER BY distance; """ printImages(client.query(query))Exécutez la cellule de code.

Le résultat doit ressembler à ce qui suit :

Effectuer un nettoyage

- In the Cloud de Confiance console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.