Pengantar BigQuery DataFrames

BigQuery DataFrames adalah sekumpulan library Python open source yang memungkinkan Anda memanfaatkan pemrosesan data BigQuery dengan menggunakan API Python yang sudah dikenal. BigQuery DataFrames menyediakan DataFrame Pythonik yang didukung oleh mesin BigQuery, dan mengimplementasikan API pandas dan scikit-learn dengan mendorong pemrosesan ke BigQuery melalui konversi SQL. Dengan begitu, Anda dapat menggunakan BigQuery untuk menjelajahi dan memproses data berukuran terabyte, serta melatih model machine learning (ML), semuanya dengan Python API.

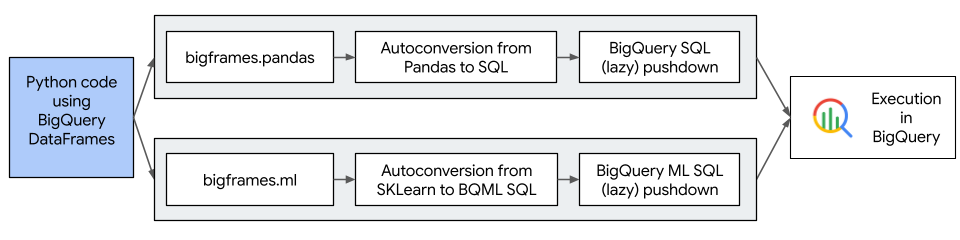

Diagram berikut menjelaskan alur kerja DataFrame BigQuery:

Manfaat BigQuery DataFrames

BigQuery DataFrames melakukan hal berikut:

- Menawarkan lebih dari 750 API pandas dan scikit-learn yang diimplementasikan melalui konversi SQL transparan ke BigQuery dan BigQuery ML API.

- Menunda eksekusi kueri untuk meningkatkan performa.

- Memperluas transformasi data dengan fungsi Python yang ditentukan pengguna untuk memungkinkan Anda memproses data di Cloud de Confiance by S3NS. Fungsi ini otomatis di-deploy sebagai fungsi jarak jauh BigQuery.

- Terintegrasi dengan Vertex AI untuk memungkinkan Anda menggunakan model Gemini untuk pembuatan teks.

Pemberian Lisensi

BigQuery DataFrame didistribusikan dengan lisensi Apache-2.0.

DataFrame BigQuery juga berisi kode yang berasal dari paket pihak ketiga berikut:

Untuk mengetahui detailnya, lihat direktori

third_party/bigframes_vendored

di repositori GitHub BigQuery DataFrames.

Kuota dan batas

- Kouta BigQuery berlaku untuk BigQuery DataFrames, termasuk komponen hardware, software, dan jaringan.

- Sebagian kecil API pandas dan scikit-learn didukung. Untuk mengetahui informasi selengkapnya, lihat API pandas yang didukung.

- Anda harus menghapus secara eksplisit fungsi Cloud Run yang dibuat secara otomatis sebagai bagian dari pembersihan sesi. Untuk mengetahui informasi selengkapnya, lihat API pandas yang didukung.

Harga

- BigQuery DataFrames adalah sekumpulan library Python open source yang tersedia untuk didownload tanpa biaya tambahan.

- BigQuery DataFrames menggunakan BigQuery, fungsi Cloud Run, Vertex AI, dan layananCloud de Confiance by S3NS lainnya, yang menimbulkan biaya tersendiri.

- Selama penggunaan reguler, BigQuery DataFrames menyimpan data sementara,

seperti hasil perantara, dalam tabel BigQuery. Tabel ini dipertahankan selama tujuh hari secara default, dan Anda akan ditagih untuk data yang disimpan di dalamnya. Tabel dibuat dalam set data

_anonymous_di project Cloud de Confiance yang Anda tentukan dalam opsibf.options.bigquery.project.

Langkah berikutnya

- Coba panduan memulai BigQuery DataFrames.

- Instal BigQuery DataFrames.

- Pelajari cara memvisualisasikan grafik menggunakan DataFrame BigQuery.

- Pelajari cara

menggunakan adaptor

dbt-bigquery.